- Entwicklung

-

Geräte

- Koordinatenmessgeräte mit Kreuztisch

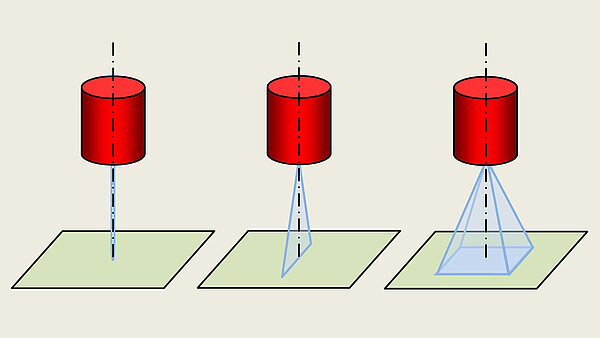

- Koordinatenmessgeräte mit Führungen in einer Ebene

- Koordinatenmessgeräte mit Portal

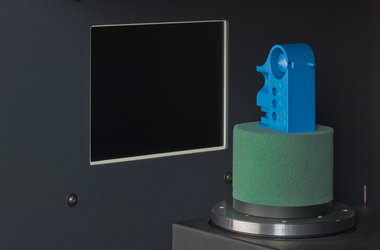

- Koordinatenmessgeräte mit Drehachsen

- Koordinatenmessgeräte für zweidimensionale Messungen

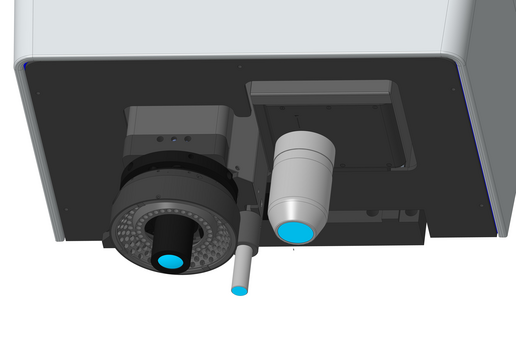

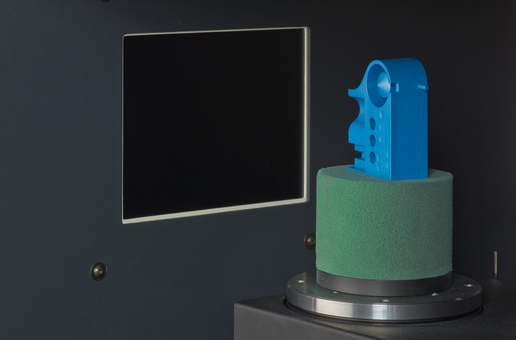

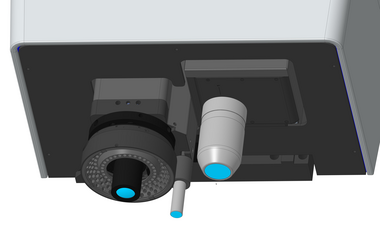

- Koordinatenmessgeräte mit Röntgentomografie

- Koordinatenmessgeräte für spezielle Anwendungen

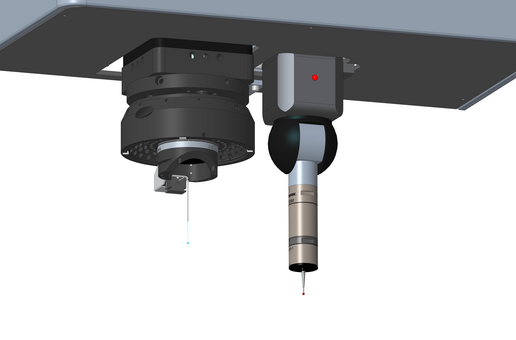

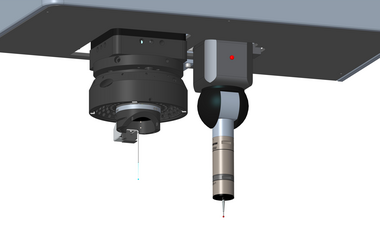

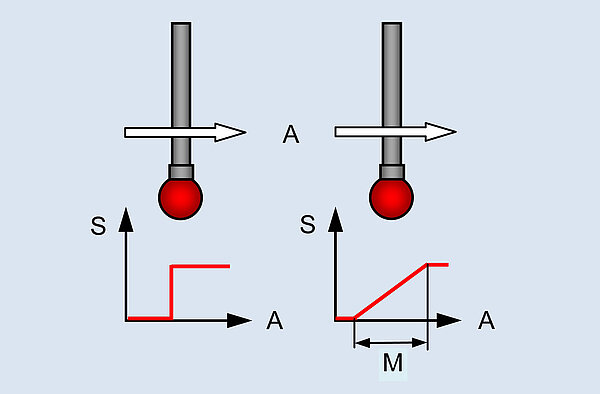

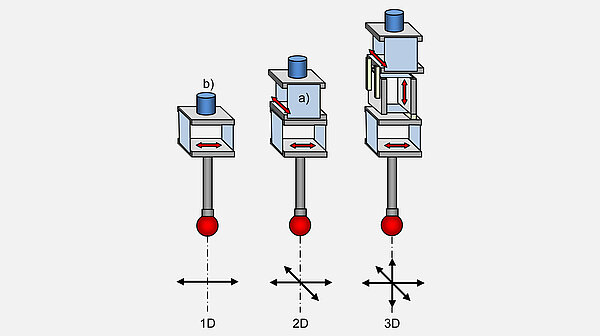

- Sensoren

- Software

- Besonderheiten

- Genauigkeit

- Veröffentlichungen

- Literaturseite