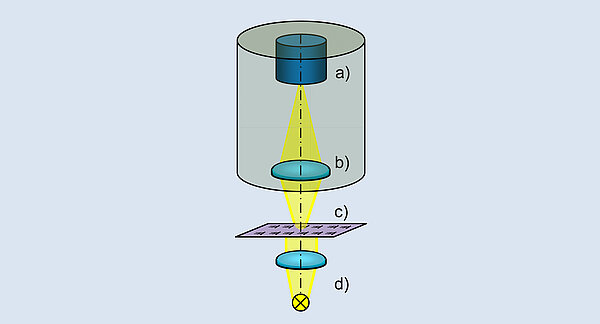

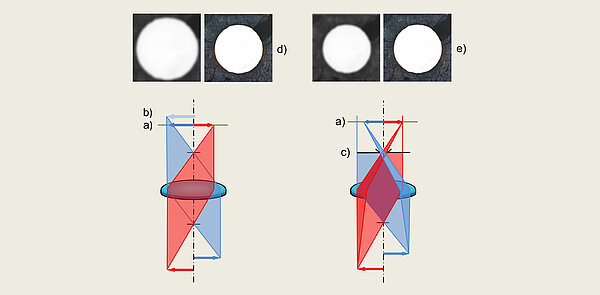

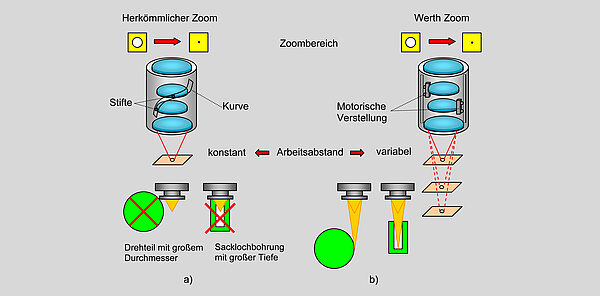

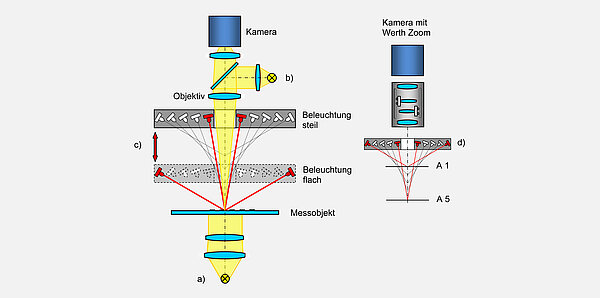

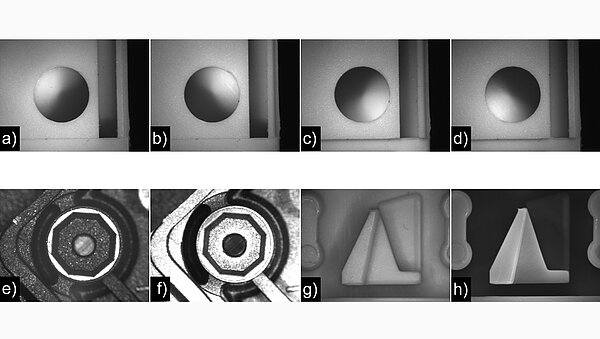

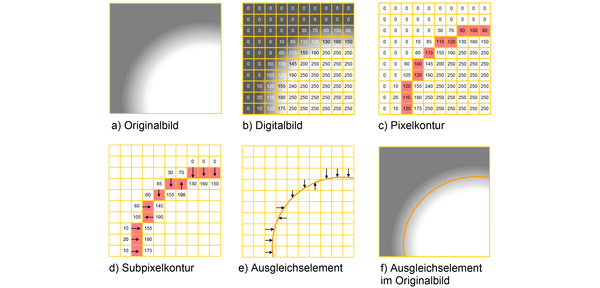

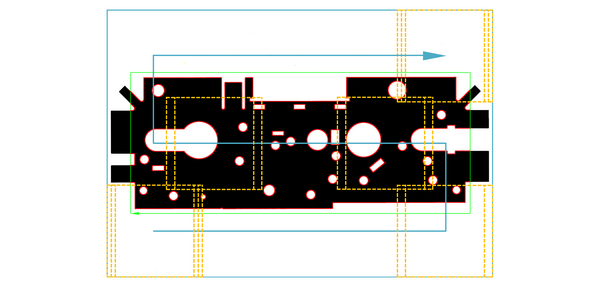

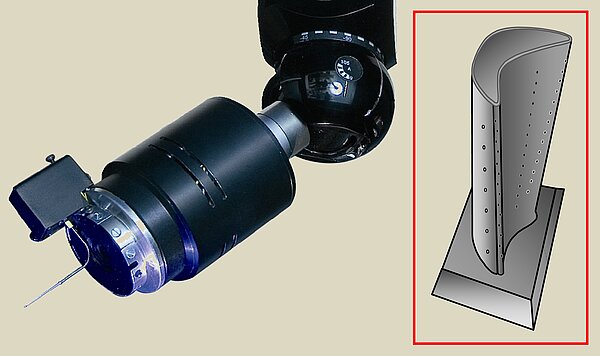

Die Bildverarbeitung gehört wegen ihrer flexiblen Einsatzmöglichkeiten sowie der guten Visualisierung des Objekts und der gemessenen Merkmale zur Grundausstattung der meisten optischen und Multisensor-Koordinatenmessgeräte. Ähnlich der Bilderzeugung beim visuellen Messen mit Messmikroskopen wird das Messobjekt in der in Abbildung 7 vereinfacht dargestellten Weise durch ein Objektiv auf eine Matrixkamera abgebildet. Die Kameraelektronik wandelt die optischen Signale in ein digitales Bild um, das zur Berechnung der Messpunkte in einem Auswerterechner mit entsprechender Bildverarbeitungssoftware herangezogen wird. Hierbei wird die Intensitätsverteilung in diesem Bild ausgewertet. Maßgeblichen Einfluss auf die Leistungsfähigkeit von Bildverarbeitungssensoren haben die Einzelkomponenten wie Beleuchtungssysteme, Abbildungsoptik, Halbleiterkamera, Signalverarbeitungselektronik und Bildverarbeitungsalgorithmen [1, 4].

- Entwicklung

-

Geräte

- Koordinatenmessgeräte mit Kreuztisch

- Koordinatenmessgeräte mit Führungen in einer Ebene

- Koordinatenmessgeräte mit Portal

- Koordinatenmessgeräte mit Drehachsen

- Koordinatenmessgeräte für zweidimensionale Messungen

- Koordinatenmessgeräte mit Röntgentomografie

- Koordinatenmessgeräte für spezielle Anwendungen

- Sensoren

- Software

- Besonderheiten

- Genauigkeit

- Veröffentlichungen

- Literaturseite